Потестировал [Time To Move](https://time-to-move.github.io/) (TTM).

Потестировал [Time To Move](https://time-to-move.github.io/) (TTM).

Это новый инструмент для управления объектами в кадре и камерой, совместимый с любыми диффузионными моделями. Используется стратегия двухтактного денойзинга (dual-clock denoising), позволяющая чётко создавать требуемые изменения в регионах под масками, и более свободно генерить содержимое вне их. Из входящего изображения извлекается карта глубины, на основе которой строится желаемое движение камеры с достраиванием недостающих кадров на основе ближайших цветов.

Вместо подачи направляющего видео или указания траектории, тут ты закидываешь начальный кадр, грубо-сделанную анимацию что как должно двигаться, плюс маску на её основе. Шевелить в кадре можно больше одного объекта. И то и другое я сделал в давинчи, но думаю есть способы проще, или даже ноды прямо в Comfy (например [MatAnyone](https://huggingface.co/spaces/PeiqingYang/MatAnyone) для получения маски). Ловите [тестовые файлики](https://github.com/time-to-move/TTM/tree/main/examples/cutdrag_wan_Monkey) для быстрого старта. С помощью Qwen IE 2509 вручил обезьянке в руки табличку Psy Eyes, и в нём же сделал вариант без обезьянки, чтобы можно было её двигать по кадру, а фон был стабильным. Можно и встроенными в фотошоп инструментами это решить.

Я тестировал [воркфлоу](https://github.com/kijai/ComfyUI-WanVideoWrapper/blob/main/example_workflows/wanvideo2_2_I2V_A14B_TimeToMove_example.json) от Kijai на основе [Wan 2.2](https://t.me/Psy_Eyes/2976) 14B на 4090 + 128 ГБ RAM. По умолчанию всё настроено генерить на fp8 весах, 480p 16fps, 6 шагов, по 3 шага на хай и лоу семплеры (далее 6/3). На одно видео уходит 25 сек/ит или ~1,5 мин на видео, что довольно шустро. Если у вас установлен torch compile и sage attention это может дать ещё буст, несколько жертвуя качеством. В моей сборки их нет, поэтому тестил без них. С подключённым блоксвапом при генерации 480p видюха потребляет ~17 ГБ VRAM, а в оперативку идёт ~12 ГБ. Если мало ресурсов, есть версии TTM для [более лайтовых](https://github.com/time-to-move/TTM?tab=readme-ov-file#run-inference-on-the-included-49-frame-cogvideox-example) видеогенераторов [SVD](https://t.me/Psy_Eyes/1490) и [CogVideoX](https://t.me/Psy_Eyes/1970).

На 3 шагах артефакты от слоя анимации ещё видны, а с 4-го уже чётко и с каждым шагом обезьянка прибавляет деталей. Текст на табличке держится хорошо даже при её наклоне и наложении теней.

Другое наблюдение: чем больше шагов, тем меньше объект следует заданной траектории и больше тусуется в центре. Возможно с увеличением шагов нужно поиграться ещё с какими параметрами в воркфлоу.

Kijai обновил ноды, и наваял [воркфлоу](https://github.com/kijai/ComfyUI-WanVideoWrapper/blob/main/example_workflows/wanvideo2_2_I2V_A14B_TimeToMove_example.json). Веса для Wan, SVD, и CogVideoX используются родные.

[Сайт](https://time-to-move.github.io/)

[Гитхаб](https://github.com/time-to-move/TTM)

[Comfy воркфлоу](https://github.com/kijai/ComfyUI-WanVideoWrapper/blob/main/example_workflows/wanvideo2_2_I2V_A14B_TimeToMove_example.json)

[Файлики для тестов](https://github.com/time-to-move/TTM/tree/main/examples/cutdrag_wan_Monkey)

Related posts

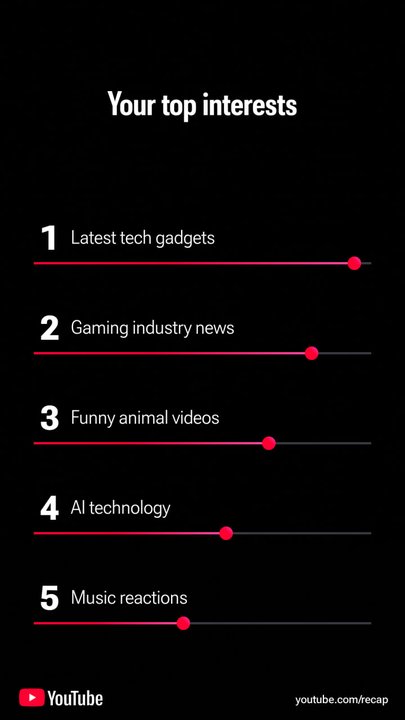

YouTube launches annual Recap summarizing watched content

Запрещёнка релизнула модель [SAM Audio]( для изоляции звуков на аудио и видео.

Scroll down to load next post